最近,图注意力网络一作 Petar Veličković 在母校剑桥大学做了一场讲座,介绍图神经网络的理论基础。

图神经网络(GNN)是机器学习中最热门的研究方向之一,在提出后的十几年里被不断扩展,先后发展出了图卷积网络、 图注意力网络、图自编码器、图生成网络和图时空网络等多个子领域。

最近,图注意力网络的第一作者 Petar Veličković 回到母校剑桥大学计算机实验室做了一场主题为《图神经网络理论基础》的讲座。在演讲中,Petar 尝试从基本原理推导 GNN,介绍其在多个学科中的应用,并解释 GNN 如何在多个研究路线中并行出现。

讲座幻灯片地址:https://petar-v.com/talks/GNN-Wednesday.pdf

Petar 表示,这个演讲「浓缩」了他 4 年 GNN 研究的精华,「这些年我用多种方式讲授 GNN,现在我终于找到了最『自然』的讲解方式。」他表示,这个 70 分钟的讲座既可以帮助初学者,也可以为 GNN 实践者提供新的角度。

Petar Veličković:我找到了最「自然」的 GNN 讲解方式

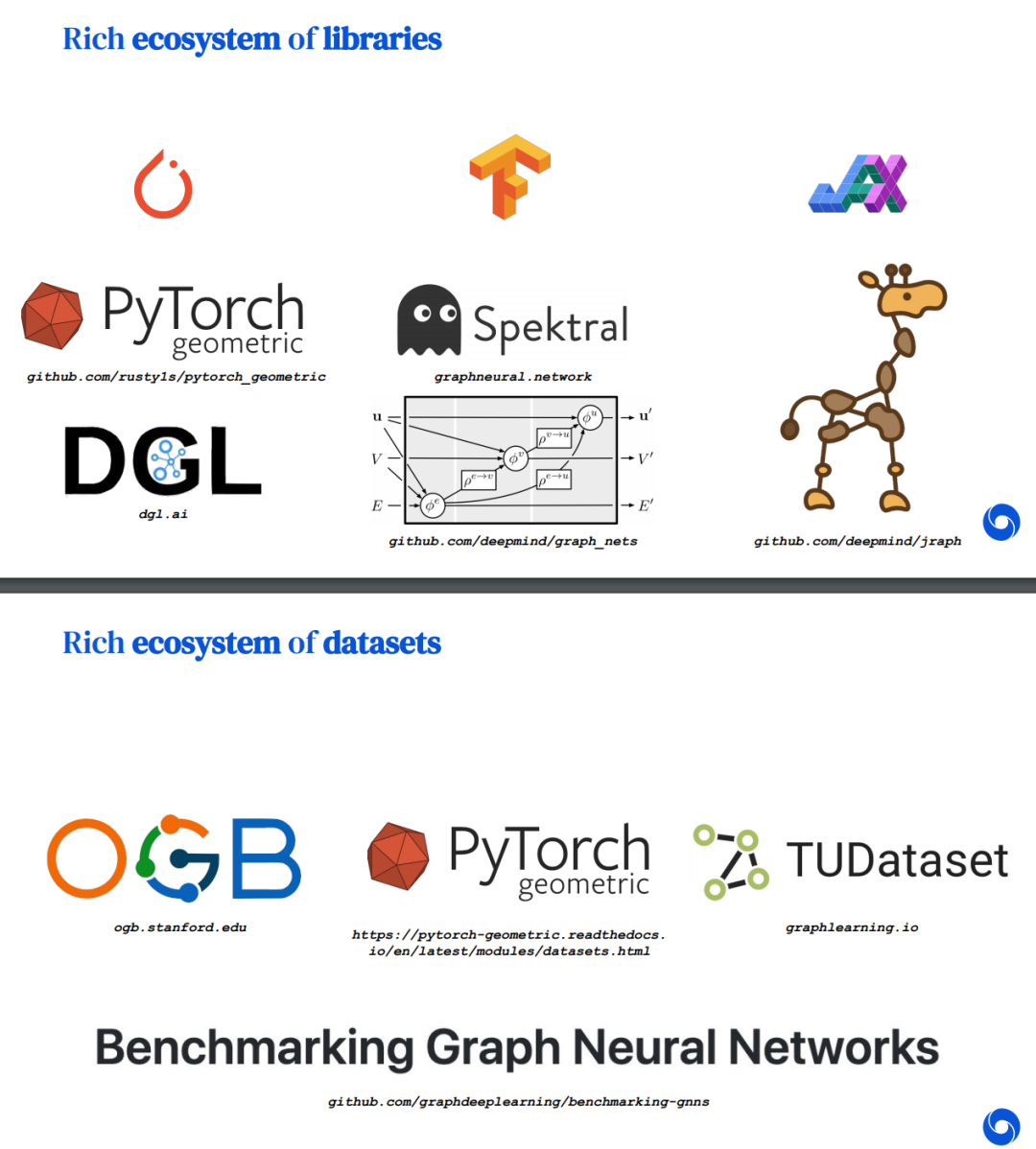

Petar 首先介绍了现实世界中的图、图神经网络的实际应用,以及 GNN 的相关库和数据集等。

- 基于基本原理推导 GNN;

- 介绍 GNN 的多个独立研究变体;

- 回顾:类 GNN 模型在 ML 研究历史中的出现;

- 当下:目前的一些研究方向;

- 展望:GNN 如何泛化至图结构输入以外。

Petar 表示,该讲座的内容基于其关于几何深度学习的研究、麦吉尔大学助理教授 William Hamilton 的著作《图表示学习》,以及 Yoshua Bengio、Marco Gori、Jürgen Schmidhuber 等多位研究者的工作。

Petar 首先从基本原理定义 GNN,然后介绍了对 GNN 处理图数据有用的特性,并列举了一些示例。

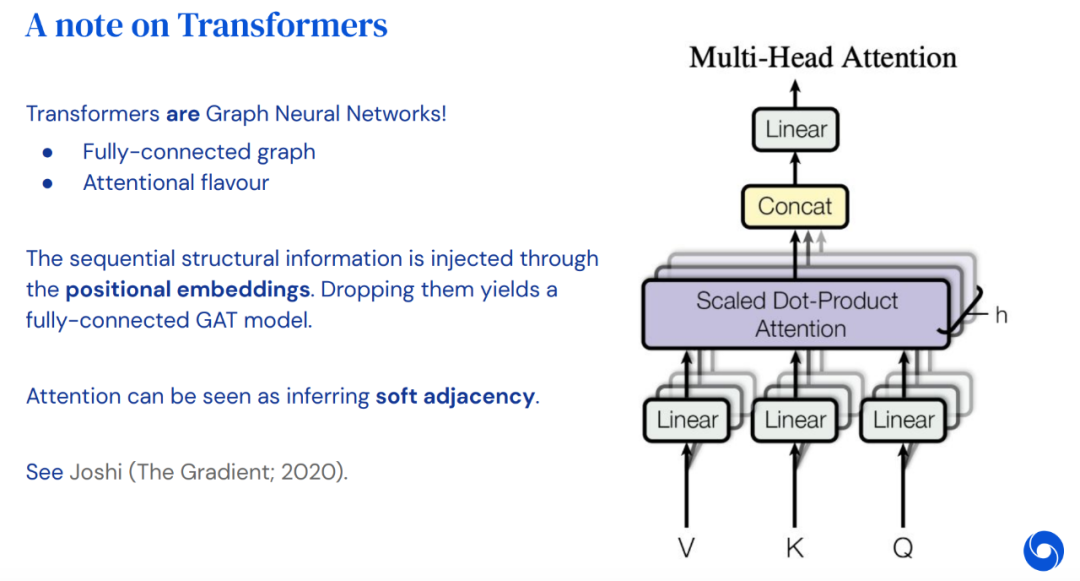

Petar 介绍了 GNN 的发展过程与研究蓝图,及其在多个研究领域中的并行出现。例如,自然语言处理与 GNN。

本文为原创文章,版权归知行编程网所有,欢迎分享本文,转载请保留出处!

内容反馈